如何获取并理解CDN业务的源码?

- 行业动态

- 2024-11-25

- 2827

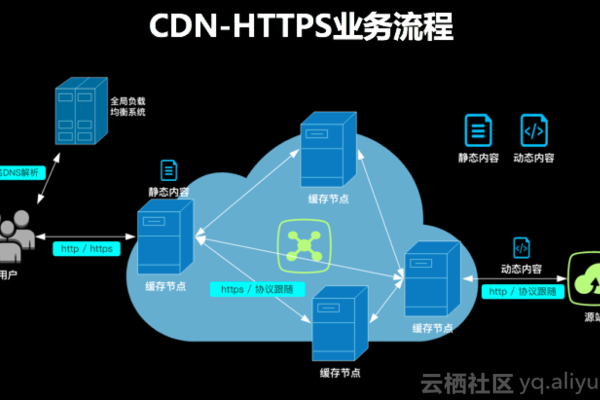

CDN(Content Delivery Network,内容分发网络)是一种通过在多个地理位置部署缓存服务器来加速网站加载速度、节省带宽成本和提高数据传输效率的技术,自建CDN需要整合多种技术和工具,从规划和需求分析到节点部署和配置,再到监控和优化,每一个步骤都至关重要。

一、规划和需求分析

在开始自建CDN之前,首先需要进行详细的规划和需求分析,这包括了解用户的地理分布情况,以便选择合适的节点位置;确定需要缓存的内容类型和流量特征,以制定合适的缓存策略;以及评估预算和硬件资源,决定是否需要租用数据中心或云服务器。

1、用户分布分析:通过分析用户访问日志,获取用户的地理位置分布数据,这些数据可以帮助你决定在何处部署CDN节点,以覆盖大多数用户。

2、内容类型分析:确定网站的主要内容类型,例如静态资源(图片、CSS、JavaScript)、动态内容(API响应)和大文件(视频、音频等),不同类型的内容对CDN的需求不同。

3、预算和资源评估:根据预算确定CDN节点的数量和配置,初期可以选择租用云服务提供商的虚拟机,逐步扩展到自建物理服务器。

二、选择合适的软件和工具

构建CDN需要多种软件和工具的支持,以下是一些常见的选择:

1、反向代理服务器:如Nginx或Apache,用于处理用户请求和缓存静态资源。

2、缓存服务器:如Varnish,用于高效缓存和快速响应。

3、负载均衡器:如HAProxy或Nginx,用于分配请求到不同的CDN节点。

4、监控和日志分析工具:如Prometheus、Grafana,用于监控节点性能和流量。

三、节点部署和配置

在确定了软件和工具后,接下来是部署和配置CDN节点,这包括选择节点位置、安装和配置软件以及DNS配置。

1、选择节点位置:根据用户分布和网络拓扑选择合适的节点位置,可以选择在主要用户集中地区部署节点,确保低延迟和高带宽。

2、软件安装和配置:在每个节点上安装Nginx、Varnish和HAProxy,并进行配置,在Nginx中配置反向代理规则,在Varnish中配置缓存策略,在HAProxy中配置负载均衡规则。

3、DNS配置:使用DNS解析将用户请求指向最近的CDN节点,可以使用GeoDNS或Anycast技术,根据用户的地理位置选择最近的节点。

缓存策略是CDN性能的关键,需要根据内容类型和访问模式制定合适的缓存策略,内容分发也需要考虑数据同步和一致性。

1、缓存策略类型和访问模式制定缓存策略,对于静态资源,可以设置较长的缓存时间;对于动态内容,可以设置较短的缓存时间或不缓存。

2、内容分发:使用工具和脚本将内容分发到不同的CDN节点,确保数据同步和一致性,可以使用rsync或其他文件同步工具,将静态资源同步到各个节点。

五、监控和优化

构建完成后,需要持续监控CDN节点的性能和流量,并进行优化。

1、性能监控:使用Prometheus和Grafana等监控工具,监控节点的CPU、内存、带宽和请求数等指标,设置告警规则,及时发现和处理问题。

2、日志分析:分析访问日志,了解用户行为和流量特征,发现潜在问题,可以通过日志分析发现缓存命中率低的问题,并进行优化。

3、优化策略:根据监控和分析结果,进行性能优化和故障排查,调整缓存策略、优化负载均衡规则、升级硬件配置等。

常见问题及解决方案

在自建CDN过程中,可能会遇到一些常见问题,需要及时解决。

1、缓存命中率低:检查缓存策略和配置,确保缓存规则正确,对于静态资源,可以设置较长的缓存时间;对于动态内容,可以设置较短的缓存时间或不缓存。

2、节点负载过高:增加节点数量或升级硬件配置,调整负载均衡规则,确保请求均匀分布到各个节点。

3、内容更新不及时:使用文件同步工具或CDN管理平台,确保内容及时更新,可以使用rsync或其他文件同步工具,将静态资源同步到各个节点。

自建CDN是一项复杂的技术工程,需要全面的规划和细致的实施,通过选择合适的软件和工具、合理的节点部署和配置、有效的缓存策略和内容分发,以及持续的监控和优化,可以构建高效的CDN系统,提升网站性能和用户体验,关键在于规划、实施和优化的每一个细节,确保系统的高效运行和持续改进。

以上内容就是解答有关“cdn业务源码”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/1233.html