CDN与COS,哪个更适合您的存储与加速需求?

- 行业动态

- 2025-01-24

- 6

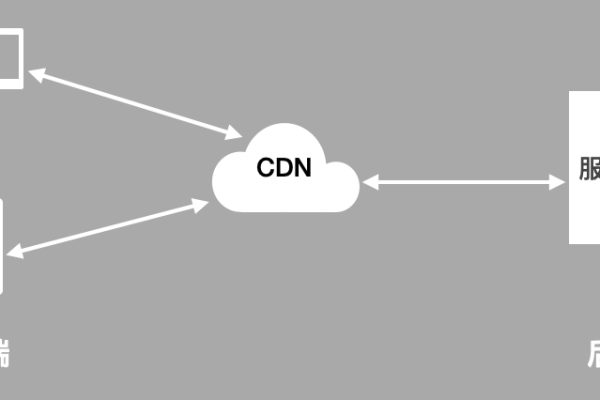

在当今数字化时代,内容分发网络(CDN)和对象存储(COS)已成为提升网站性能和用户体验的关键技术,CDN 通过全球分布的节点加速内容传输,而 COS 则提供高效、安全的文件存储服务。

CDN 与 COS 的对比

1、功能特性:

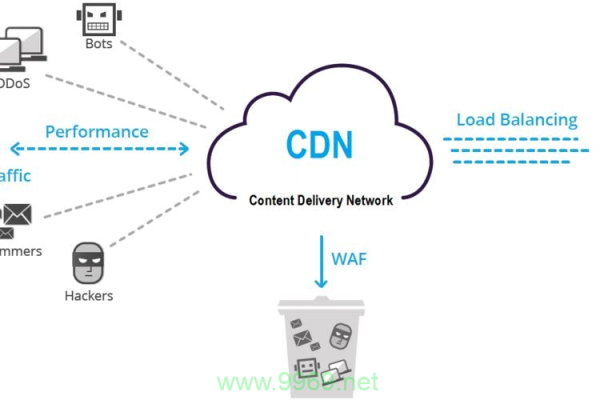

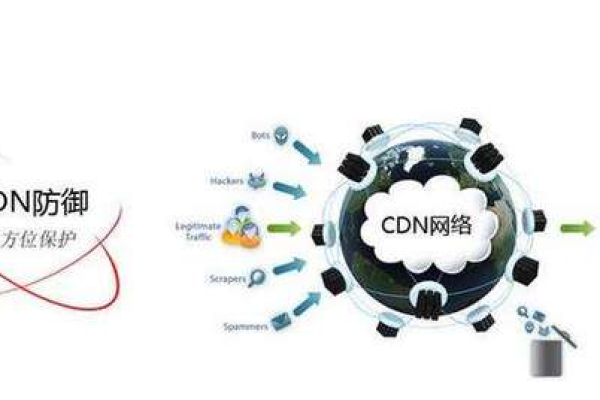

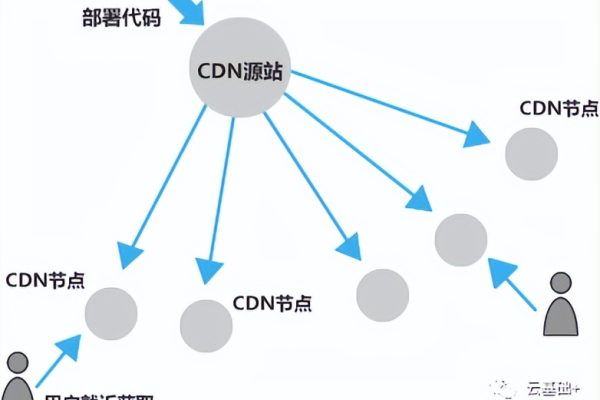

CDN:主要功能是利用分布式节点技术,将网站内容分发到离用户最近的服务器,提高访问速度和稳定性,降低网络拥塞和延迟,还能减轻源站压力并提供安全防护。

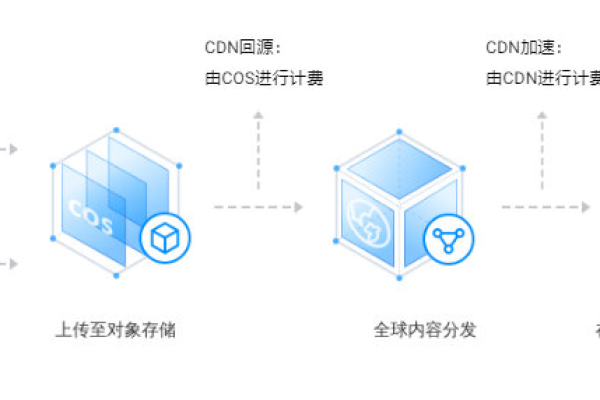

COS:是一种云存储服务,可存储海量文件,具有高扩展性、低成本、可靠安全等优点,支持多格式文件上传、下载和管理,可作为 CDN 的源站存储静态资源。

2、适用场景:

CDN:适用于对网站加速、视频直播、软件分发等场景有较高要求的情况,能有效解决网络带宽小、用户访问量大、网点分布不均等问题,如大型视频分享网站、在线游戏平台等。

COS:适合需要存储大量静态资源,如图片、视频、文档等文件的场景,常被用于网站静态资源的存储和管理,以及作为各种应用的数据存储后端,如图片素材网站、数据备份等。

3、性能表现:

CDN:能显著提升网站的加载速度和响应时间,通过智能路由和负载均衡技术,让用户从最近或最优的节点获取内容,减少数据传输距离和时间,还可应对突发流量,确保网站稳定运行。

COS:本身主要提供存储功能,其性能体现在存储容量、读写速度和数据可靠性上,可快速上传和下载文件,保证数据的持久性和完整性,但在内容分发的速度和效率上不如 CDN。

4、成本费用:

CDN:使用 CDN 服务通常需要支付一定的费用,包括流量费用、存储费用、请求次数费用等,不同 CDN 服务提供商的收费标准有所不同,流量越大、加速区域越广,费用越高。

COS:COS 的费用主要包括存储空间费用、流量费用等,其成本较为固定,主要取决于存储容量和使用时长,对于大规模存储需求,费用可能会较高。

5、安全性:

CDN:可以提供一定的安全防护机制,如 DDoS 攻击防护、源站隐藏等,防止反面攻击和非规访问,保护源站的安全。

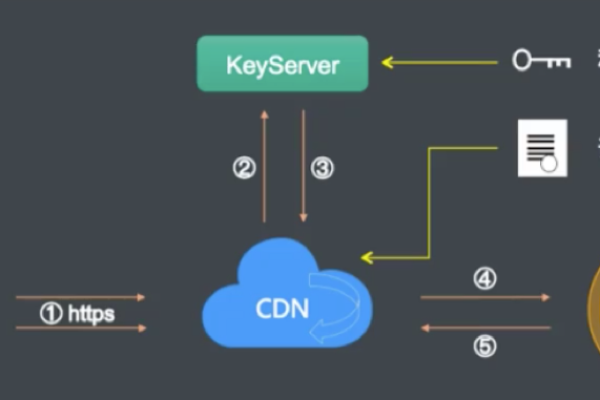

COS:具备严格的权限控制和访问管理机制,只有授权用户才能访问存储的文件,同时采用数据加密技术,保障数据在传输和存储过程中的安全性。

相关 FAQs

1、问题:CDN 和 COS 能否结合使用?

回答:可以结合使用,将 COS 作为 CDN 的源站存储静态资源,由 CDN 进行全球加速分发,这样既能利用 COS 的可靠存储,又能发挥 CDN 的加速优势,提高网站性能和用户体验,还可以节省成本。

2、问题:如何选择适合自己的 CDN 或 COS 服务?

回答:选择 CDN 服务时,需考虑加速效果、节点分布、价格、技术支持等因素;选择 COS 服务时,要关注存储容量、读写速度、安全性、成本等,建议根据具体的业务需求、预算和使用场景来综合评估和选择。