自建CDN的原理是什么?

- 行业动态

- 2025-01-08

- 2

自建CDN(内容分发网络)的原理涉及多个关键步骤和组件,其核心目标是通过在全球各地部署缓存节点,将常用的静态内容复制并存储在这些节点上,从而加速用户对内容的访问速度,减少延迟,提升用户体验,以下是自建CDN原理的详细阐述:

一、CDN

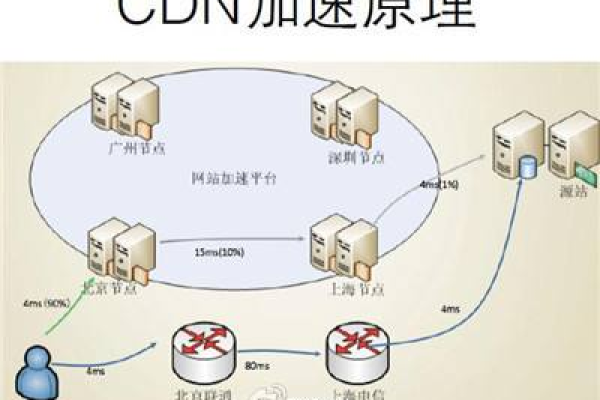

CDN是一种分布式的网络架构,用于提高互联网内容的分发效率,它通过在网络各处放置节点服务器,构成现有的互联网基础之上的一层智能虚拟网络,当用户访问已经加入CDN服务的网站时,其解析请求将指向该CDN服务的全局负载均衡设备(如DNS服务器),该设备根据用户的IP地址,将其域名解析请求重定向到离用户最近的节点服务器上,从而提高用户访问网站的响应速度。

二、CDN工作原理

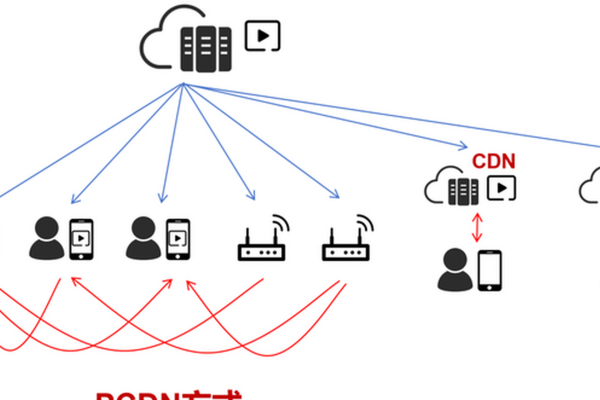

1、内容推送(Push):首先将源站的内容推送到CDN的边缘节点,这可以通过手动配置或使用自动化工具来实现。

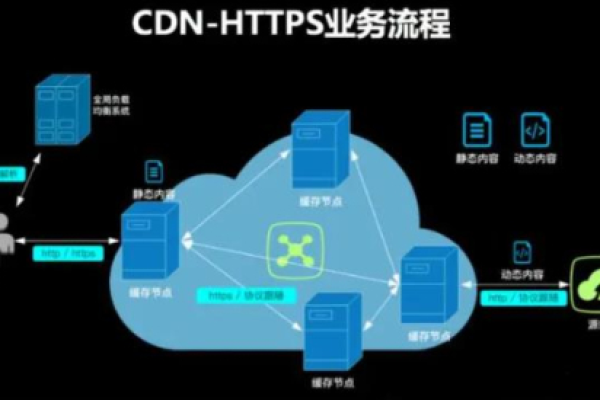

2、请求调度:当用户发起请求时,CDN的智能调度系统会根据用户所在地理位置、网络状况等因素选择最佳的边缘节点提供服务,这一过程通常涉及DNS解析技术,将用户访问的域名映射到离用户最近的服务器上。

3、内容响应:用户从最近的边缘节点获取内容,从而降低延迟,如果边缘节点上没有所需的内容(即缓存未命中),节点会将请求转发给源服务器,获取内容后再返回给用户,并在本地缓存该内容以供后续访问。

4、缓存策略:CDN会根据缓存淘汰算法(如LRU,Least Recently Used)自动更新缓存内容,确保热点内容始终被缓存,还可以设置缓存头、缓存时间等参数来优化缓存效果。

三、构建自建CDN的关键步骤

1、选择合适的技术栈:根据项目需求选择合适的后端语言(如Node.js、Python、Go等)和前端负载均衡器(如Nginx、HAProxy等)。

2、搭建边缘节点:在全球范围内选择合适的机房搭建边缘节点,确保覆盖广泛,这些节点可以是物理服务器或云服务器。

3、推送机制:将源站内容实时或定期推送到各个边缘节点,可以使用开源工具如rsync或专门的推送工具来实现。

4、设计高效的请求调度算法:基于地理位置、IP地址、DNS解析等因素设计请求调度算法,确保用户请求能够被路由到最优的边缘节点。

5、制定合适的缓存策略:根据业务需求制定缓存策略,包括设置缓存头、缓存时间、缓存失效策略等。

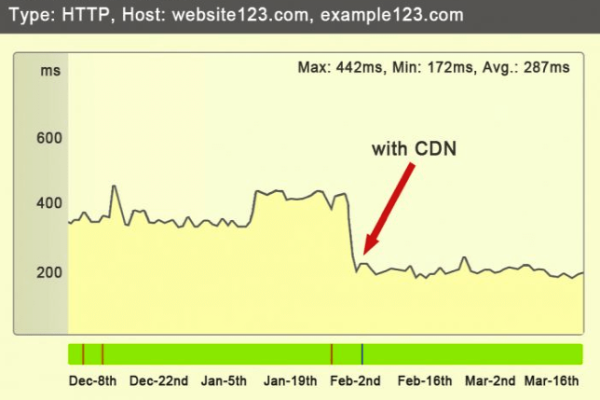

6、部署监控系统:实时监控CDN的运行状况,包括流量、请求量、响应时间等指标,使用日志分析工具对日志数据进行处理和分析,以便快速定位问题。

7、加强安全措施:部署WAF(Web应用防火墙)、防盗链、防DDoS攻击等安全措施,确保CDN服务的安全性。

四、相关问答FAQs

Q: 自建CDN的优势有哪些?

A: 自建CDN的优势包括更高的带宽和更快的访问速度、更好的网络稳定性和可靠性、更灵活的内容分发策略和缓存规则、更好的数据安全和隐私控制,以及更低的成本和更好的性价比。

Q: 自建CDN需要哪些技术和知识?

A: 自建CDN需要具备网络架构和配置知识、服务器硬件和软件配置知识、域名解析和DNS设置知识、CDN软件的安装和配置经验、网络性能测试和监控技能,以及网络安全和防护知识。

五、小编有话说

自建CDN是一项复杂而系统的工程,需要从多个方面进行规划和实施,通过合理的规划和实施,可以建立一个高效、稳定、安全的CDN系统,为用户提供优质的访问体验,对于大多数企业和个人来说,直接使用成熟的第三方CDN服务可能是一个更为经济和高效的选择,因为这样可以省去自建CDN所需的大量人力、物力和财力投入,对于一些对数据安全和隐私控制有较高要求的场景,自建CDN仍然是一个值得考虑的选项。