当计算机显示DNS服务器未响应时,我们应该如何排查和解决问题?

- 行业动态

- 2024-08-25

- 10

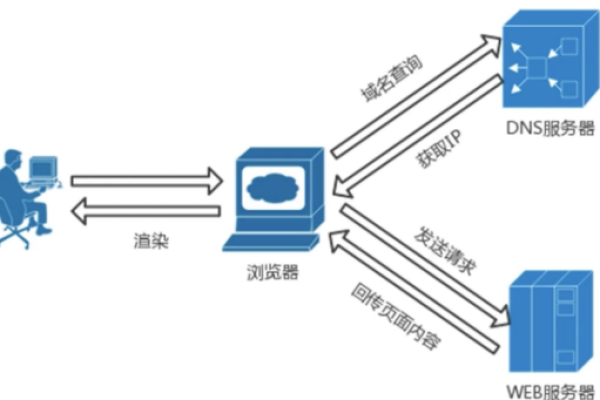

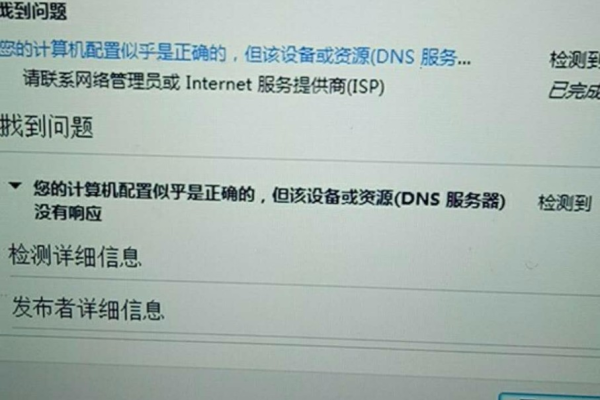

当计算机在进行网络连接时,可能会遇到“DNS服务器未响应”的错误提示,这种情况表明计算机无法从DNS(Domain Name System)服务器获取响应,从而影响到网络的正常浏览和使用,下面将分析“计算机DNS服务器未响应”的意义及可能的解决方案:

1、DNS服务器的作用

域名解析:DNS服务器负责将人类可读的网站域名翻译为机器可读的IP地址。

网络连接必需:没有DNS服务器的响应,计算机无法解析网站地址,导致无法访问网页。

2、故障原因分析

网络服务商问题:可能正遇到网络服务商的暂时性故障或者维护更新。

路由器或接线问题:硬件故障如路由器或ADSL猫损坏,网线接触不良等也会导致该问题。

电脑系统设置问题:系统的网络设置不当也可能导致DNS服务器未正常响应。

3、解决方案

重置网络设置:通过命令提示符执行’netsh winsock reset’来重置网络设置。

手动设置DNS:更改DNS服务器地址至公共DNS,如8.8.8.8和114.114.114.114。

启动DNSClient服务:确保DNSClient服务处于运行状态并设置其为自动启动。

排查硬件故障:检查路由器、ADSL猫或网线等硬件是否正常工作,必要时更换故障硬件。

联系网络服务商:咨询网络服务供应商,了解是否存在服务端的问题。

在解决“DNS服务器未响应”的问题时,以下是一些注意事项和考虑因素:

保持耐心,部分问题可能是由于网络服务商的服务器暂时性故障导致,这可能需要一段时间自动恢复。

安全操作,重置网络设置和更改DNS服务器地址时应确保操作正确,避免进一步的网络配置错误。

定期检查,即使解决了当前的问题,也应定期检查网络硬件及设置,防止类似问题再次发生。

当计算机出现“DNS服务器未响应”的提示时,用户应先进行系统和网络设置的核查与修正,其次排查硬件问题,若问题依旧存在,则最好咨询网络服务商,通过这些步骤,大多数关于DNS服务器未响应的问题都能得到有效的解决,对于日常用户来说,了解和掌握这些基本的故障排除方法,将有助于提升网络问题的自助解决能力。