什么是CDN守望先锋?它如何改变游戏行业的网络体验?

- 行业动态

- 2025-01-05

- 3

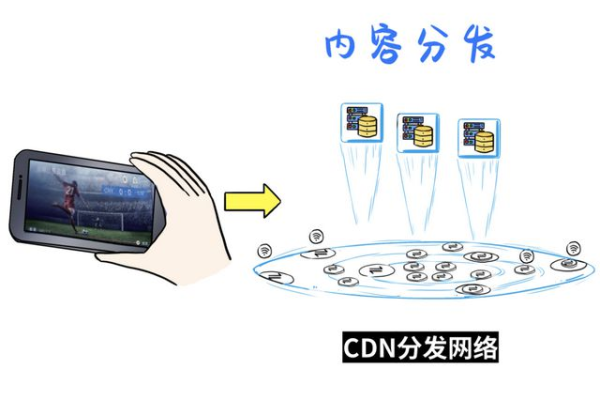

守望先锋是一款由暴雪娱乐开发的团队射击游戏,自2016年发布以来,一直受到广大玩家的喜爱,为了提升游戏的下载速度和加载速度,很多玩家选择使用CDN(内容分发网络)技术来优化游戏体验,本文将详细介绍守望先锋的CDN配置情况,并提供一些常见问题的解答和建议。

守望先锋CDN配置情况

CDN厂商与分布节点

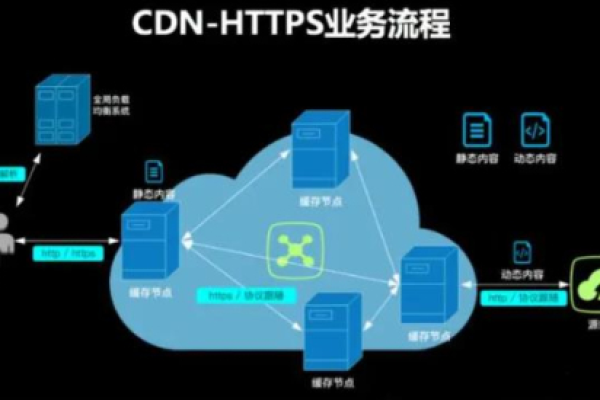

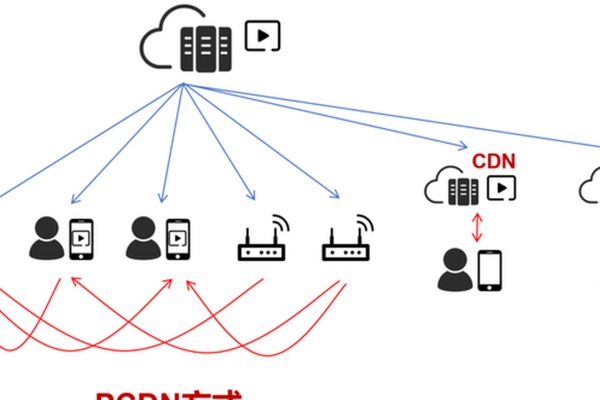

守望先锋的CDN厂商为阿里云,其CDN分布节点主要分布在亚洲、欧洲和美洲等地区,覆盖范围广泛,这种全球性的节点分布可以确保玩家在各个地区都能获得较快的下载速度和较低的延迟。

CDN缓存时间

守望先锋的CDN缓存时间为1天,这意味着CDN节点会将游戏资源缓存一天,以提高后续访问的速度,对于热门游戏来说,这样的缓存时间设置是合理的,可以在保证资源更新的同时,提高用户体验。

CDN配置步骤

要获取守望先锋的CDN配置,玩家可以按照以下步骤操作:

1、登录官方网站:打开守望先锋官网(https://playoverwatch.com/),并选择您的游戏区域。

2、进入CDN配置页面:在登录后,找到游戏设置菜单下的CDN配置页面。

3、配置CDN服务器地址和端口:在CDN配置页面上,输入您的CDN服务器地址和端口,然后保存设置。

4、测试CDN配置:完成配置后,在游戏设置菜单中选择测试CDN配置,确保配置成功。

常见问题解答

Q1: 如何选择合适的CDN加速器?

A1: 玩家可以根据自己的地理位置和网络环境,尝试不同的CDN加速器,选择最适合自己的加速器,常见的CDN加速器有阿里云、腾讯云等。

Q2: CDN配置失败怎么办?

A2: 如果CDN配置失败,可以尝试以下几个步骤:

确保网络连接稳定。

检查输入的CDN服务器地址和端口是否正确。

尝试重新启动游戏或电脑。

如果问题仍然存在,可以联系守望先锋的客服支持。

Q3: CDN配置对游戏性能有何影响?

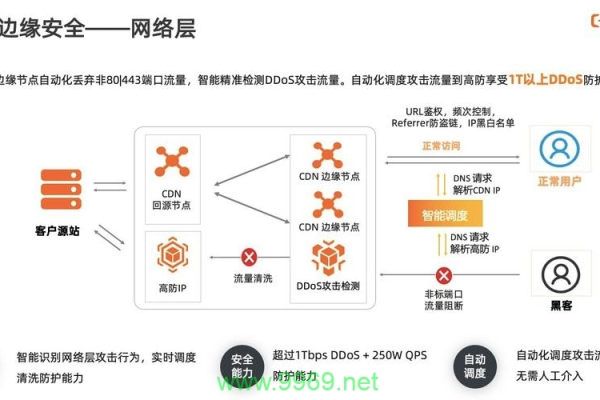

A3: CDN配置可以提高游戏的下载速度和加载速度,降低延迟,从而提高游戏的流畅度和稳定性,这对于竞技类游戏尤为重要,因为任何延迟都可能影响玩家的操作和游戏体验。

守望先锋的CDN配置对于提升游戏体验至关重要,通过合理配置CDN,玩家可以获得更快的下载速度和更稳定的游戏连接,希望本文提供的信息能够帮助玩家更好地理解守望先锋的CDN配置,并解决在使用过程中遇到的问题。