探漫服务器究竟指的是什么?

- 行业动态

- 2024-08-05

- 4

对于漫画爱好者而言,探漫平台提供了丰富多彩的漫画资源,而探漫的服务器则是支撑这些数字资源能够被顺畅访问和下载的硬件和技术基础,探漫的服务器是一种计算机硬件设备,用于存储、处理和传输探漫平台的数据和信息,是保障平台运行稳定、数据安全和用户访问流畅的关键设施,小编将展开详细讨论探漫服务器的多重作用和意义:

1、基础设施的角色

数据中心的组成部分:探漫的服务器通常放置在专业的数据中心内,这些数据中心的环境被精心设计以保护服务器免受物理和网络安全威胁。

高可靠性和稳定性:通过使用由多个物理服务器组成的集群,探漫能够提供高可靠性和稳定性的服务,确保平台的服务持续可用。

2、核心的数据存储

用户数据的保管者:探漫的服务器负责存储用户的个人信息、账号数据等,保证用户信息的安全与隐私。

漫画资源的集散地:平台上所有漫画资源、评论、用户交互信息等都被存储在服务器上,并进行备份,以确保数据的安全性和可靠性。

3、网络传输的枢纽

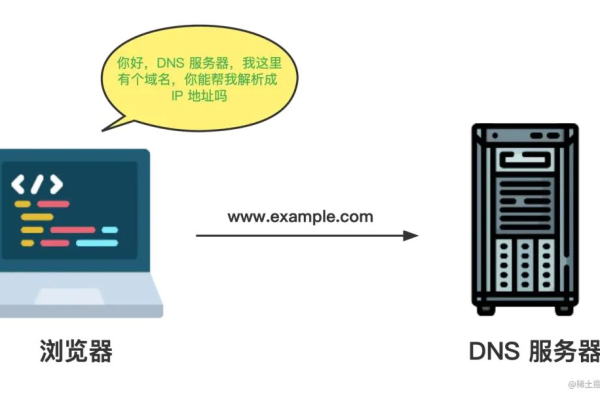

实现互联网连接:探漫的服务器利用互联网进行数据传输,使得用户可以通过不同设备连接到服务器,享受平台上的资源和服务。

支持多设备访问:不管是电脑、手机还是平板等,用户都可以通过网络顺利访问探漫的服务器,并使用其提供的服务。

4、性能监测的执行者

评估服务器状态:通过对服务器进行检测和测试,即“探活”,可以确定服务器是否正常运行,对其性能、可用性和稳定性进行评估。

预防和解决问题:探活可以帮助及时发现并解决潜在的服务器问题,保持服务质量。

5、参与主体的多样性

探活的多方参与:进行服务器探活的可能是消费者(Consumer)、注册中心或者是某个单独的探活组件,这保障了从多方面确保服务器的活跃和有效性。

被动探活:在某些情况下,消费者处于被动状态,根据需要对服务器进行探活。

6、用户体验的守护者

流畅访问的保障者:服务器的高效运转直接影响着用户的访问体验,快速响应用户请求,提供流畅的浏览和下载体验。

安全交易的促成者:对于付费漫画等内容,服务器还承担着安全处理交易信息的任务,确保用户财产安全。

7、技术创新的推动者

适应时代发展:随着技术的进步,服务器也在不断地更新换代,以适应更高的数据处理和传输需求。

新型服务的支持者:采用云技术提供服务,提高服务器的灵活性和可扩展性。

为了更全面地理解探漫服务器的作用,以下几点也值得关注:

数据中心的安全性对服务器的保护至关重要,应选择信誉良好的服务商。

数据备份和恢复策略要到位,以防万一发生故障或意外情况。

了解服务器探活的具体方式和时机,以便更好地维护系统稳定性。

探漫的服务器是维系平台正常运营的核心,它不仅仅是存储数据的仓库,更是确保用户获得优质漫画阅读体验的重要媒介,通过保持在数据中心的专业管理和定期的服务器探活,探漫能够保证用户享受到稳定可靠的服务,用户在使用平台时,也应注意自己的行为可能对服务器造成的压力,合理使用资源,共同营造一个健康、稳定的数字化阅读环境。