如何实现MQTT服务器与客户端之间的通信?MQTT客户端接入指南

- 行业动态

- 2024-11-14

- 10

一、MQTT服务器搭建

1、下载与安装:

从EMQX官网下载适合操作系统版本的MQTT Broker,Windows用户可以下载emqx-windows-v4.1-rc.2.zip。

解压文件并进入bin目录。

2、启动服务器:

运行以下命令启动EMQX服务器:

sudo systemctl start emqx

查看服务器状态:

journalctl -xe | grep "emqx"

3、访问控制台:

在浏览器中输入http://127.0.0.1:18083,使用默认用户名和密码(admin/admin)登录。

二、MQTT客户端接入说明

1、下载MQTT客户端工具:

推荐使用MQTT.fx工具,可以从官网下载对应版本,如mqttfx-1.7.1-windows-x64.exe。

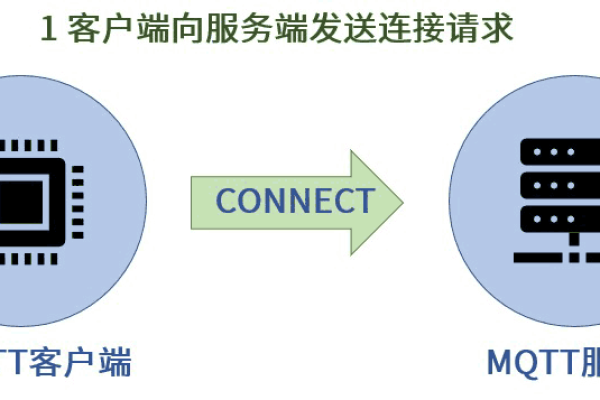

2、创建连接:

打开MQTT.fx,点击设置按钮,创建新连接。

填写主机地址(如127.0.0.1),端口号(默认为1883),并点击“Apply”保存设置。

3、连接到MQTT服务器:

选择刚才创建的连接,点击“Connect”按钮进行连接。

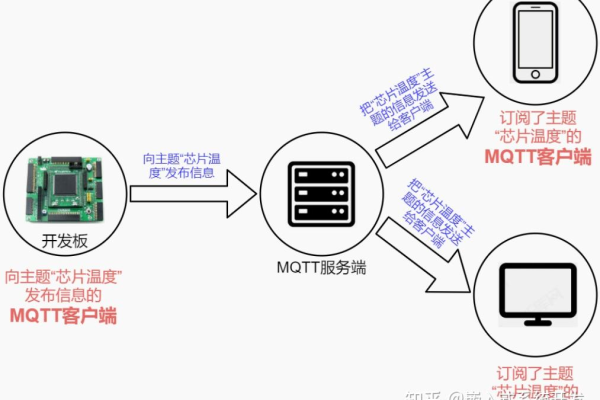

4、订阅主题:

切换到“Subscribe”页面,输入要订阅的主题(如topic1),选择QoS等级(如QoS0),然后点击“Subscribe”按钮完成订阅。

5、发布消息:

切换到“Public”页面,输入主题(如topic1)、消息内容(如test message)和QoS等级(如QoS0),点击“Publish”按钮发布消息。

6、查看订阅消息:

切换到“Subscribe”页面,可以看到已接收到的消息内容。

三、MQTT协议介绍

1、协议特点:

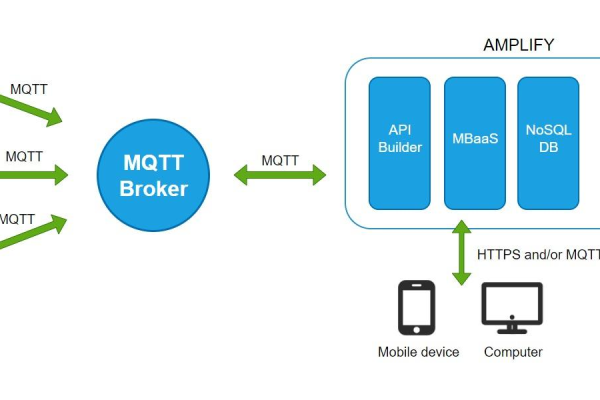

MQTT是一种基于代理的轻量级即时通讯协议,采用发布/订阅模式。

它支持一对多的消息发布,解除了应用程序间的耦合关系。

MQTT提供三种服务质量(QoS):至多一次、至少一次和刚好一次。

2、消息类型:

MQTT协议定义了多种消息类型,包括CONNECT、CONNACK、PUBLISH、PUBACK等。

每种消息类型都有特定的头部信息和可变头部信息。

四、MQTT客户端配置说明

1、连接配置:

MQTT客户端接入物联网平台时,需要获取平台的接入域名和端口号(如8883)。

客户端身份认证参数包括clientId、username和password。

2、预置接入凭证:

如果首次使用或忘记接入凭证,可以通过调用生成接入凭证接口或前往控制台页面进行预置。

通过以上步骤和说明,可以成功搭建MQTT服务器并实现客户端的接入与通信。

以上内容就是解答有关“mqtt服务器与客户端通信_MQTT客户端接入说明”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。