RAID级别的区别:RAID 0、RAID 1、RAID 5、RAID 6和RAID 10

- 行业动态

- 2024-06-02

- 5

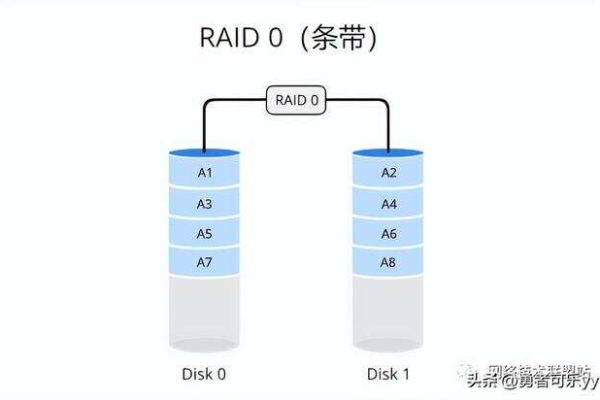

RAID 0

定义与工作原理

RAID 0,也称为条带化(striping),是一种将数据分割成块并跨多个硬盘并行存储的方法,这种方式不提供冗余或容错功能,其目的是提高读写速度和性能。

特点

性能提升:通过并行读写,提高了数据传输速率。

无冗余:不提供数据备份,如果任何一个硬盘失败,所有数据都会丢失。

容量利用:所有硬盘的容量总和用于存储数据。

适用场景

适用于需要高性能而非数据冗余的场合,如游戏、视频编辑等。

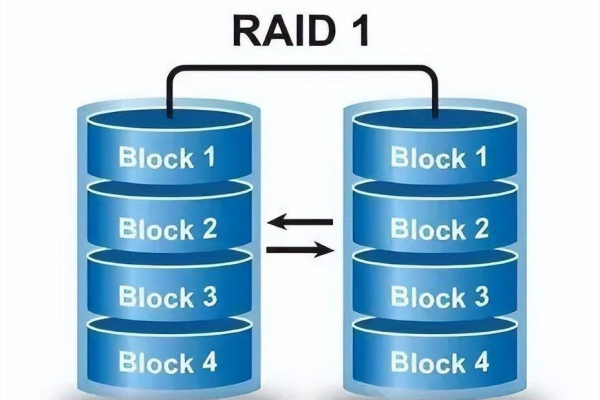

RAID 1

定义与工作原理

RAID 1,也称为镜像(mirroring),通过将数据完全复制到两个或多个硬盘上来实现数据冗余。

特点

数据冗余:每个硬盘都有数据的完整副本,提高数据安全性。

读取性能提升:可以从任一副本读取数据,提高读取速度。

写入性能:由于数据需要写入所有副本,写入速度可能受到影响。

容量利用:实际可用的存储空间等于最小的硬盘容量。

适用场景

适用于需要高数据可靠性的环境,如服务器和关键业务应用。

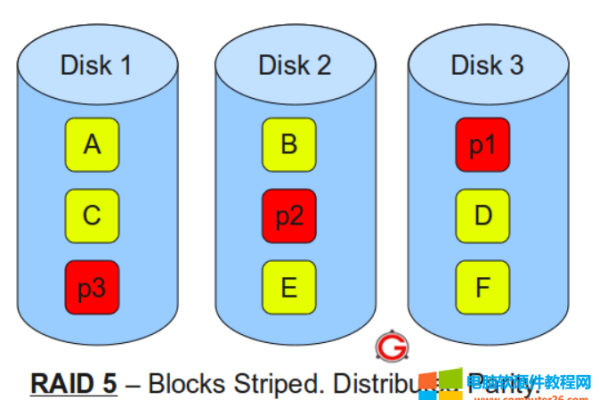

RAID 5

定义与工作原理

RAID 5结合了条带化和奇偶校验技术,数据和奇偶校验信息被分布在所有硬盘上。

特点

数据冗余:一个硬盘的失败不会丢失数据。

读取性能:类似于RAID 0,但受奇偶校验计算的影响。

写入性能:每次写入都需要计算和更新奇偶校验信息,性能低于RAID 0。

容量利用:(N1)/N,其中N为硬盘数量。

适用场景

适用于需要平衡性能和数据冗余的场景,如数据库服务器。

RAID 6

定义与工作原理

RAID 6在RAID 5的基础上增加了第二个独立的奇偶校验算法,可以容忍两个硬盘同时失败。

特点

双重数据冗余:更高的数据保护水平。

读取性能:类似RAID 5,但更复杂。

写入性能:比RAID 5更低,因为需要两次奇偶校验计算。

容量利用:(N2)/N。

适用场景

适用于极端情况下需要极高数据保护的环境,如大型数据中心。

RAID 10

定义与工作原理

RAID 10,也称为1+0,是RAID 1和RAID 0的结合,先做镜像再做条带化。

特点

数据冗余与性能:结合了RAID 1的镜像和RAID 0的条带化优点。

读取和写入性能:通常优于其他RAID级别。

容量利用:一半硬盘的容量,因为是镜像。

适用场景

适用于需要极高数据保护和最优性能的环境,如高性能工作站和关键业务系统。

相关问答FAQs

Q1: RAID 5和RAID 6的主要区别是什么?

A1: RAID 5使用单奇偶校验,而RAID 6使用双奇偶校验,因此RAID 6可以容忍两个硬盘同时失败,而RAID 5只能容忍一个,这导致RAID 6在写入性能上稍逊于RAID 5,但提供了更高的数据保护级别。

Q2: 为什么RAID 10的性能通常优于其他RAID级别?

A2: RAID 10通过结合镜像和条带化技术,不仅提供了数据冗余,还优化了数据的分布方式,减少了磁盘寻道时间,从而提高了读取和写入性能,它允许多个磁盘操作同时进行,进一步提高了性能。