端口隔离是什么?为什么需要端口隔离、如何实现端口隔离?一文解惑!使用(端口隔离和vlan隔离区别)

- 行业动态

- 2024-05-18

- 11

端口隔离是什么?

端口隔离是一种网络技术,用于将一个物理端口分割成多个逻辑端口,每个逻辑端口都可以独立配置和管理,通过端口隔离,可以将不同的网络流量隔离开来,提高网络安全性和性能。

为什么需要端口隔离?

1、安全性:端口隔离可以防止不同用户之间的网络流量相互干扰和攻击,每个逻辑端口只能与特定的设备通信,减少了潜在的安全风险。

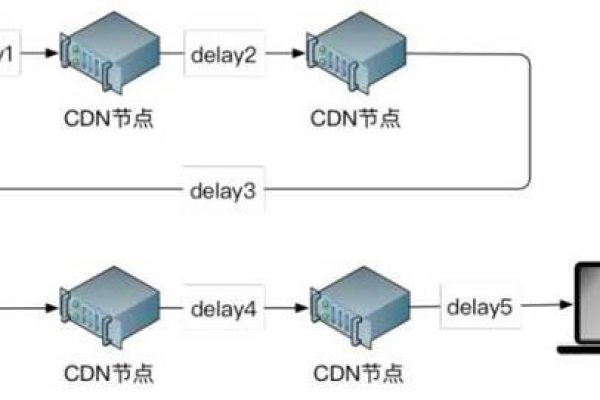

2、性能优化:通过将不同的网络流量隔离到不同的逻辑端口上,可以避免网络拥塞和冲突,提高网络的性能和吞吐量。

3、管理灵活性:每个逻辑端口都可以独立配置和管理,可以根据需求对不同的用户或应用程序进行定制化的网络设置。

如何实现端口隔离?

实现端口隔离的方法有多种,其中常见的有以下两种:

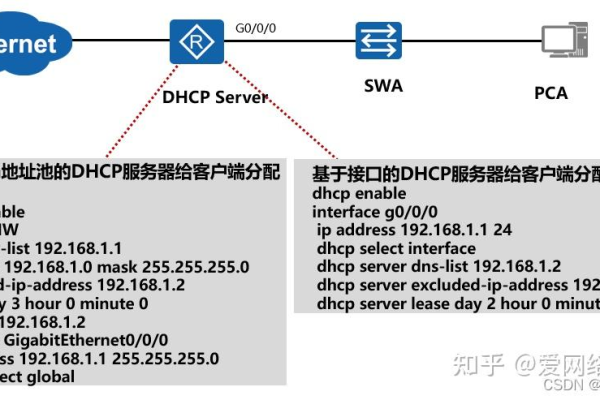

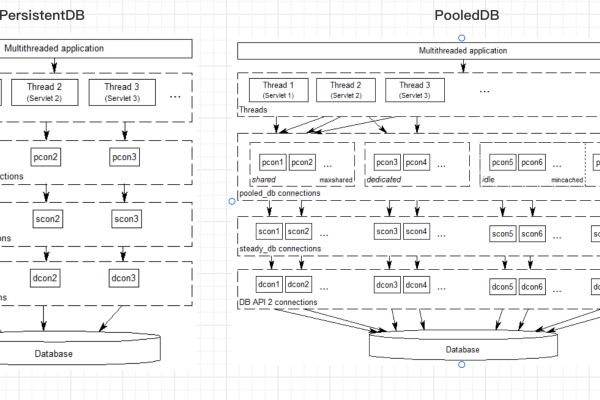

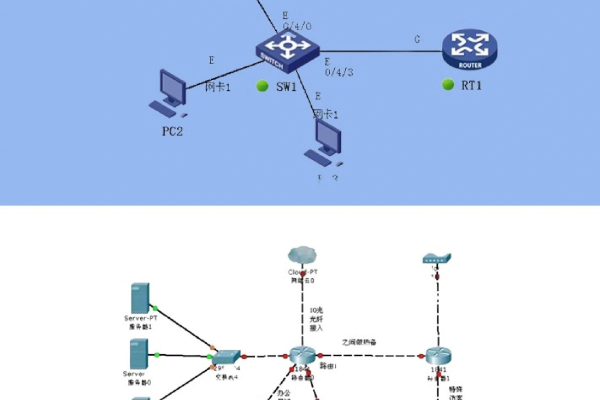

1、物理隔离:使用交换机或路由器等网络设备提供的物理隔离功能,将不同的物理端口分配给不同的用户或应用程序,每个物理端口只能连接一台设备,从而实现了物理上的隔离。

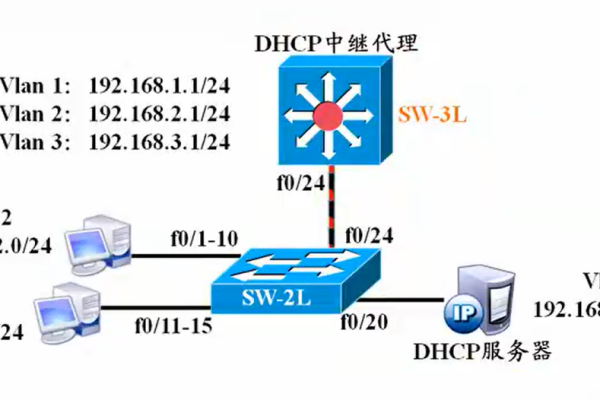

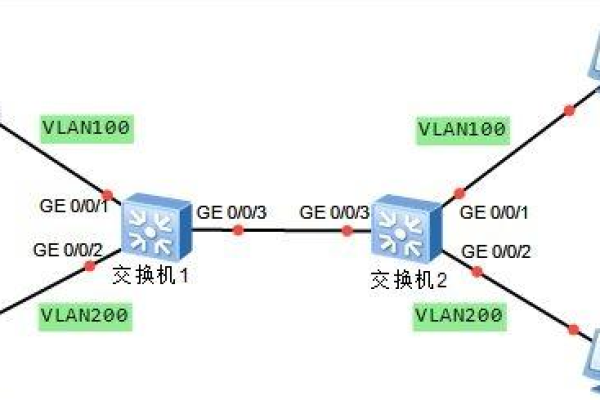

2、VLAN隔离:使用虚拟局域网(VLAN)技术,将不同的逻辑端口划分到不同的VLAN中,每个VLAN代表一个独立的广播域,不同VLAN之间的通信需要通过路由器进行转发,通过将不同的用户或应用程序划分到不同的VLAN中,可以实现逻辑上的隔离。

端口隔离和VLAN隔离的区别:

| 区别点 | 端口隔离 | VLAN隔离 |

| 实现方式 | 物理隔离 | 逻辑隔离 |

| 设备要求 | 需要支持物理隔离功能的网络设备 | 需要支持VLAN技术的交换机和路由器 |

| 安全性 | 高安全性,每个物理端口只能连接一台设备 | 中等安全性,不同VLAN之间需要通过路由器进行转发 |

| 管理灵活性 | 每个物理端口只能配置一种网络设置 | 每个VLAN可以独立配置网络设置 |

| 扩展性 | 受限于物理设备的端口数量 | 受限于VLAN的数量和路由器的能力 |

相关问题与解答:

问题1:在实际应用中,如何选择端口隔离还是VLAN隔离?

答:选择端口隔离还是VLAN隔离取决于具体的需求和环境,如果需要更高的安全性和控制能力,可以选择端口隔离;如果需要更灵活的网络管理和扩展性,可以选择VLAN隔离,还需要考虑设备的支持情况和成本等因素。

问题2:端口隔离和VLAN隔离是否可以同时使用?

答:是的,端口隔离和VLAN隔离可以同时使用,可以通过将不同的物理端口划分到不同的VLAN中,再将每个VLAN中的设备连接到相应的物理端口上,实现更高级别的网络隔离和安全控制。