c语言中pow怎么用

- 行业动态

- 2024-03-22

- 3

在C语言中,pow函数用于计算一个数的幂,它是数学库中的一个函数,位于math.h头文件中,要使用pow函数,首先需要包含math.h头文件,然后在代码中调用该函数并传入相应的参数。

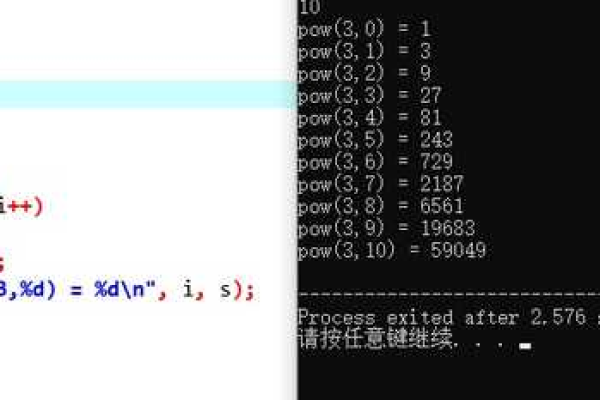

pow函数的原型如下:

double pow(double x, double y);

x是底数,y是指数,函数返回值为x的y次方,如果结果溢出,将返回一个特殊的值(通常是正无穷大或负无穷大)。

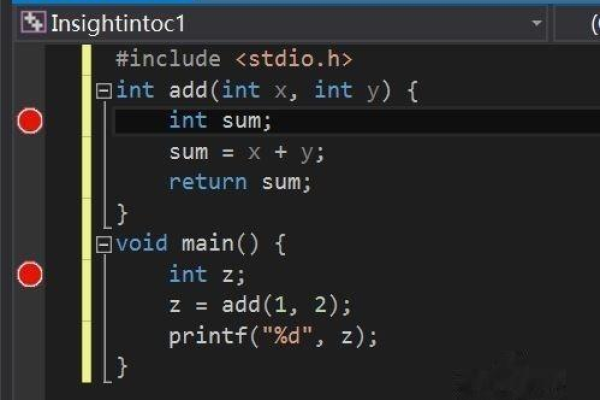

下面是一个简单的示例,演示了如何使用pow函数计算一个数的幂:

#include <stdio.h>

#include <math.h>

int main() {

double base, exponent, result;

printf("请输入底数:");

scanf("%lf", &base);

printf("请输入指数:");

scanf("%lf", &exponent);

result = pow(base, exponent);

printf("%.2lf 的 %.2lf 次方等于 %.2lf

", base, exponent, result);

return 0;

} 在这个示例中,我们首先包含了stdio.h和math.h头文件,我们声明了三个双精度浮点数变量:base、exponent和result,接下来,我们使用scanf函数从用户那里获取底数和指数的值,并将它们分别存储在base和exponent变量中,我们调用pow函数计算底数的指数次方,并将结果存储在result变量中,我们使用printf函数输出结果。

注意:在使用pow函数时,需要注意以下几点:

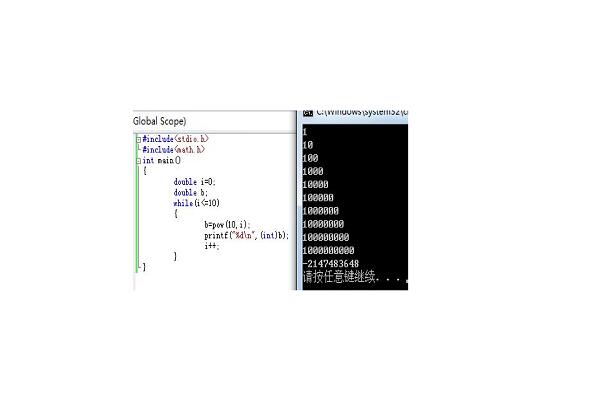

1、pow函数返回的是双精度浮点数,即使结果是一个整数,如果你需要一个整数结果,可以使用类型转换函数(如(int)result)将结果转换为整数。

2、如果底数为0且指数为非正数,或者底数为负数且指数小于0,那么结果将是未定义的,在实际编程中,应避免这种情况。

3、如果指数为0,那么结果将是1。pow(2, 0)将返回1。

4、如果指数为1,那么结果将是底数本身。pow(2, 1)将返回2。

5、如果指数大于1,那么结果将大于底数。pow(2, 3)将返回8。

6、如果指数小于1,那么结果将小于底数。pow(2, 1)将返回0.5。

7、如果指数为非整数,那么结果将是一个浮点数。pow(2, 1.5)将返回一个接近3的值。

8、pow函数不会检查溢出情况,在计算非常大或非常小的幂时,可能会导致溢出,在这种情况下,可以使用其他方法(如循环)来计算幂以避免溢出问题。

9、pow函数的性能可能不如直接使用乘法运算符(如result = base * base * base;)计算幂,但在大多数情况下,这种性能差异可以忽略不计,只有在对大量数据进行幂运算时,才需要考虑性能问题。

在C语言中,我们可以使用pow函数来计算一个数的幂,要使用它,首先需要包含math.h头文件,然后在代码中调用该函数并传入相应的参数,在使用pow函数时,需要注意一些特殊情况,以避免未定义的行为和潜在的溢出问题。