如何在Linux环境中高效处理超大文件?

- 行业动态

- 2024-09-16

- 3

在Linux中编辑超大文件,可以使用分页程序如 less或 more进行查看,使用 split命令分割文件,或者使用支持大文件的文本编辑器如 vim和 emacs进行编辑。

在处理Linux上的超大文件时,通常会遇到一些挑战,如打开和编辑这些文件时可能会消耗大量内存或造成系统缓慢,Linux操作系统提供了多种工具和技巧来高效地处理这类大文件,本文将详细介绍在Linux环境下编辑大文件的有效方法,涵盖命令行工具、文本编辑器选择、以及其他高效工具的使用。

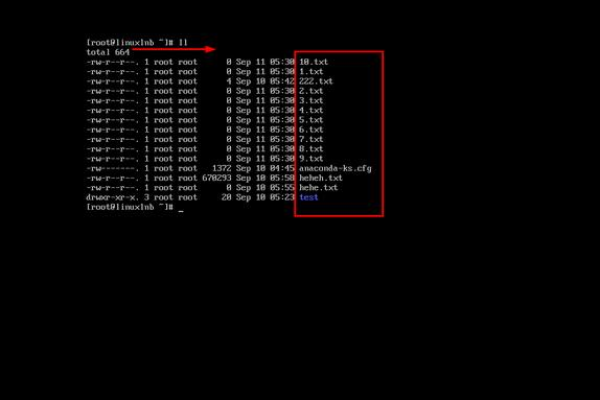

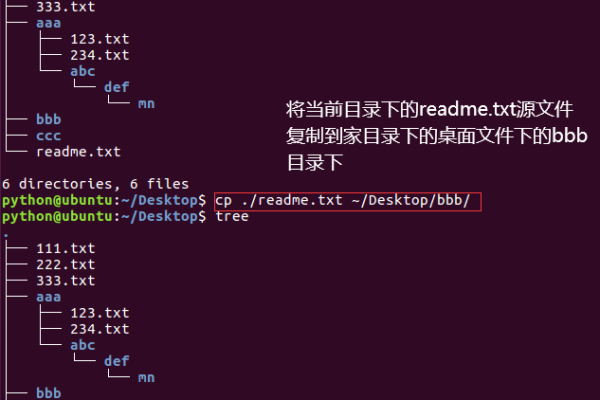

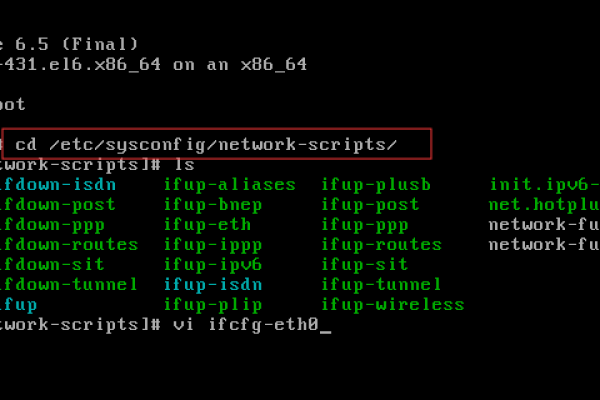

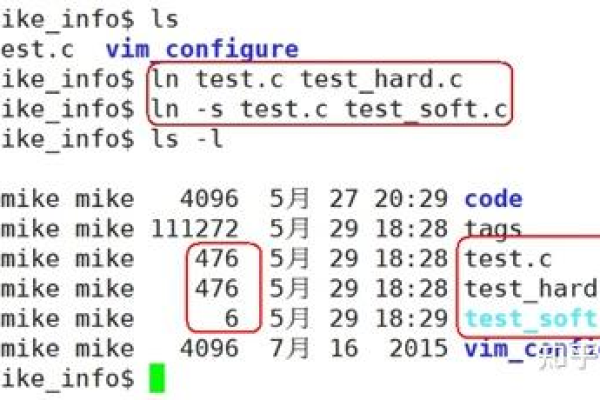

了解如何在Linux中使用split命令分割大文件是基础,该命令允许用户将一个大文件分割成多个小文件,这样更易于管理和编辑,通过简单地指定一个分隔文件的大小,例如使用split b 10M inputfile,就可以将一个大文件分割成多个10MB的小文件,这种方法尤其适用于那些单个文件大小超出常规文本编辑器能够舒适处理的情况。

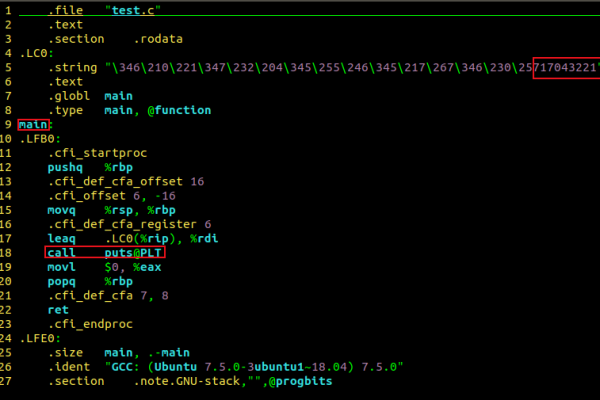

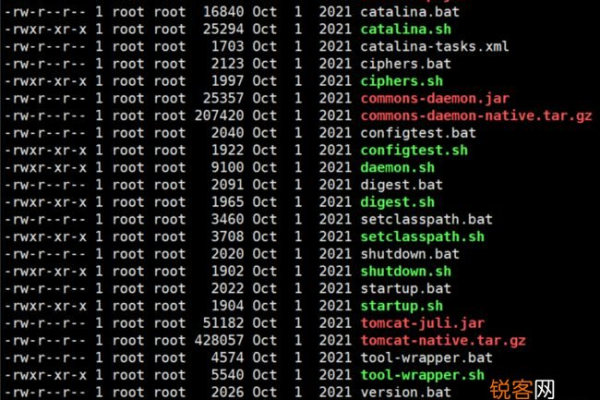

对于需要频繁编辑的大文件,使用支持大文件的文本编辑器是关键,Vim 和 JOE 是两款能够在Linux上处理大文件的优秀文本编辑器,Vim 文本编辑器拥有大量的插件,如LargeFile插件,专门用于优化大文件的加载和编辑过程,而JOE 则是一款少有的能支持打开和编辑比物理内存还要大的文件的文本编辑器,JOE 还支持各种功能强大的文本编辑操作,如非破坏性编辑和使用正则表达式进行搜索。

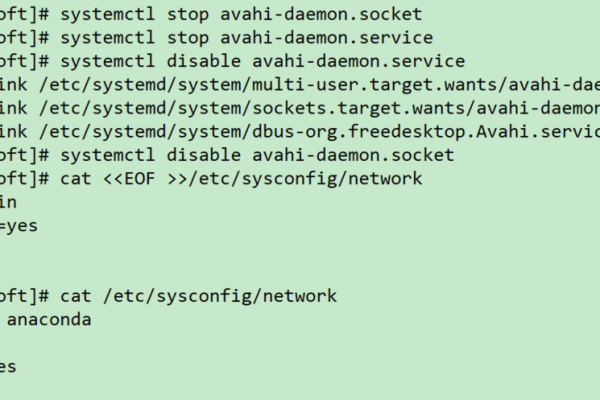

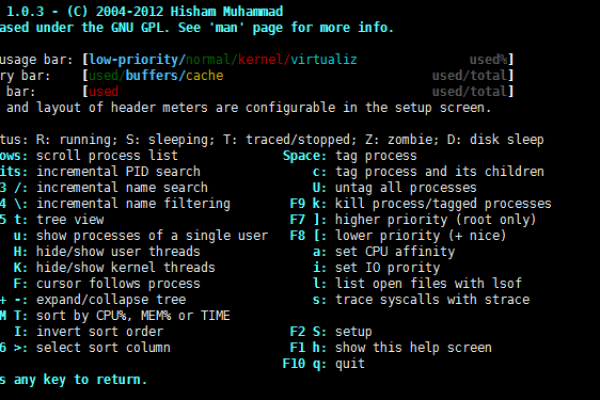

当涉及到数据流处理时,利用Linux的管道操作可以有效地对大文件进行流式处理,通过结合使用cat,grep,awk等命令,用户可以在不实际打开整个文件的情况下对文件内容进行处理,使用cat largefile | grep 'specific pattern' | less命令序列,可以在不加载整个文件到内存的情况下查看包含特定模式的行。

除此之外,使用高效的工具和库如pandas和logstash也是处理大文件的有效方式,这些工具专为处理大规模数据集设计,能够提供高性能的数据解析和转换功能,pandas库在Python中广泛应用于数据处理,它能够高效地读取和处理大型CSV文件,同时提供丰富的数据分析功能。

为帮助读者更好地理解和应用上述方法,以下是一些实用的FAQs:

如何在Linux中使用Vim处理大文件?

使用Vim编辑器处理大文件时,推荐安装LargeFile插件,这个插件可以帮助Vim更高效地读取和编辑大文件,避免因文件过大而导致的性能问题,用户可以通过Vim的插件管理器vundle或pathogen来安装LargeFile插件,安装后,在编辑大文件时Vim会自动采用优化的方式处理文件,从而改善编辑体验。

如何处理超过系统内存大小的大文件?

当文件大小超过系统可用内存时,传统的文本编辑器可能无法有效处理,此时可以考虑使用如JOE这类专门为大文件设计的文本编辑器,JOE编辑器通过特殊的文件处理机制,允许用户编辑那些大小远超内存的文件,利用Linux的split命令将文件分割成多个小文件处理也是一种有效的解决办法。

归纳而言,在Linux系统中编辑超大文件需要采用合适的工具和方法,通过上述介绍的命令行工具、文本编辑器选择,以及高效工具的使用,用户可以有效地处理这些大文件,提高工作效率,希望这些信息能够帮助用户更好地在Linux环境中管理大文件。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/103674.html