如何有效搭建CDN以优化网站性能和用户体验?

- 行业动态

- 2024-08-11

- 3

CDN搭建是一个涉及网络优化、内容分发和缓存策略等多个方面的技术过程,通过在不同地理位置部署服务节点,实现快速、高效地将内容传递给终端用户,下面将详细介绍如何搭建CDN,包括关键步骤与技术考量:

1、基本概念

加速访问:通过多个节点缓存,用户可以就近获取数据,降低延迟。

增加带宽:静态资源通过CDN加速,节约服务器带宽资源。

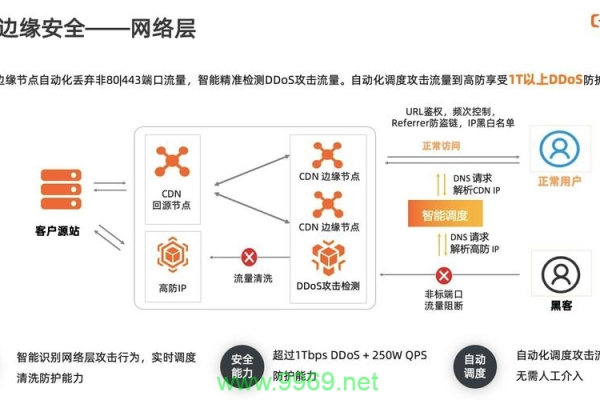

源站保护:配置CDN可以隐藏服务器的直接IP,增加攻击难度。

2、配置思路

端口配置:根据应用类型选择合适的端口,如HTTPS的443或HTTP的80端口。

实际状况考虑:确定哪些文件类型需要缓存以及其它相关配置。

3、关键技术

内容存储:在边缘服务器储存内容,快速响应用户需求。

内容分发:智能调度系统保证用户能从最近的节点获取数据。

4、搭建步骤

选择位置:全球各地数据中心部署机器,形成缓存集群。

设置缓存:配置各节点的缓存规则和存储内容。

5、自建CDN介绍

Lumanager使用:参考安装教程和搭建CDN的具体步骤。

优势分析:根据实际需求选择适合的自建CDN工具和策略。

6、优化策略

性能监控:定期监测CDN性能并做出相应调整。

安全措施:实施安全策略防止DDoS等网络攻击。

7、注意事项

节点选择:依据用户分布选择最优的节点位置。

缓存策略:合理设置缓存时间与更新频率,平衡加载速度和内容新鲜度。

8、场景案例

大型网站应用:为高流量网站提供稳定的快速访问体验。

小型个人博客:也可实现简易版CDN加速,改善访问质量。

在深入了解CDN搭建的过程中,还需要考虑以下因素:

成本效益分析:评估CDN服务的成本与带来的效益,尤其是在商业用途中。

合规性与法规:确保CDN搭建遵守当地互联网法规,避免法律问题。

技术支持与维护:选择有良好技术支持的CDN服务提供商,确保系统的稳定运行。

搭建CDN是一个涉及多个方面考量的复杂过程,不仅要考虑技术细节,还要对成本、法律以及后续的维护有所准备,通过上述步骤和策略的实施,可以构建一个既高效又稳定的CDN系统,以提升最终用户的访问体验。