qq如何Q点

- 行业动态

- 2024-05-07

- 8

QQ点,也被称为Q币,是腾讯公司推出的一种虚拟货币,用户可以通过购买QQ点来购买QQ的各种服务和产品,如QQ会员、QQ音乐、QQ游戏等,如何在QQ上获取Q点呢?以下是一些常见的获取Q点的方法:

1、在线购买:用户可以直接在腾讯的官方网站或者相关的电商平台上购买Q点,购买时,用户需要提供自己的QQ账号和支付方式,然后按照提示完成购买。

2、手机充值:用户也可以通过手机进行Q点充值,用户需要下载并安装腾讯的手机应用,然后登录自己的QQ账号,在应用的“我的”或者“钱包”页面,用户可以找到Q点充值的选项,按照提示完成充值。

3、QQ卡充值:腾讯还推出了QQ卡,用户可以使用QQ卡在指定的地点进行Q点充值,QQ卡可以在腾讯的官方网站或者其他的电商平台上购买。

4、QQ会员服务:如果用户已经是QQ会员,那么他们可以通过续费会员服务来获取Q点,在会员服务到期前,用户可以在会员中心选择续费,然后按照提示完成续费。

5、QQ活动奖励:腾讯会定期举办各种活动,用户可以通过参加这些活动来获取Q点作为奖励,活动的具体内容和奖励会在活动公告中详细说明。

6、QQ游戏奖励:在QQ游戏中,用户也可以通过完成任务或者赢得比赛来获取Q点作为奖励。

以上就是获取Q点的常见方法,需要注意的是,不同的获取方法可能会有不同的限制和要求,用户在获取Q点时需要根据自己的实际情况选择合适的方法。

FAQs:

Q1:我可以用微信支付购买Q点吗?

A1:不可以,目前,腾讯只支持使用QQ钱包、银行卡、QQ卡等方式进行Q点购买,不支持使用微信支付。

Q2:我可以用Q点购买所有的QQ服务吗?

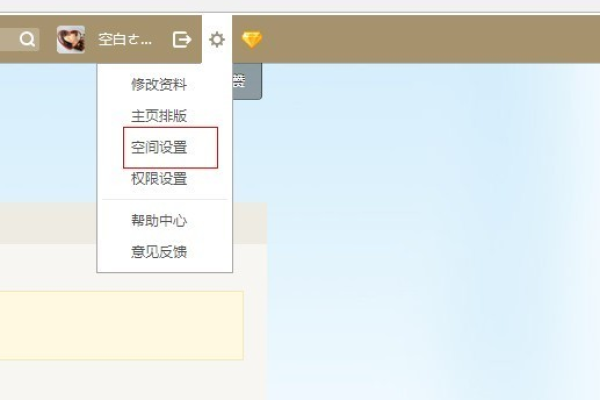

A2:不是的,虽然大部分的QQ服务都支持使用Q点购买,但是还有一些特殊的服务是需要使用其他方式购买的,例如QQ靓号、QQ空间装扮等,在使用Q点购买服务时,用户需要注意查看服务的购买说明。

获取Q点并不复杂,用户可以根据自己的需求和方便程度选择合适的获取方法,只要注意遵守腾讯的规定,就可以顺利地获取和使用Q点。

在获取和使用Q点的过程中,用户可能会遇到一些问题,例如购买失败、充值不到账等,这时,用户可以联系腾讯的客服进行咨询和解决,腾讯的客服会在工作时间内提供在线服务,用户可以通过QQ、微信、电话等方式联系客服。

腾讯还会定期发布关于Q点的公告和通知,用户可以通过关注腾讯的官方网站或者社交媒体账号来获取这些信息,这些信息可以帮助用户了解Q点的最新的获取方式、使用规则和服务内容,从而更好地使用Q点。