手机包月如何取消

- 行业动态

- 2024-05-07

- 3

手机包月服务通常包括各种类型的订阅,如音乐流媒体、视频流媒体、新闻应用、游戏等,这些服务通常会在每个月的固定日期自动从你的银行账户或信用卡中扣除费用,如果你不再需要这些服务,或者想要更换其他服务提供商,你可能需要取消手机包月服务,以下是一些取消手机包月服务的步骤和提示。

1. 确定你的服务提供商

你需要知道你的服务提供商是谁,这可能是Apple、Google Play、Spotify、Netflix等,你可以在你的手机上找到这个信息,通常在“设置”或“账户”部分。

2. 登录你的账户

一旦你知道了你的服务提供商,你需要登录你的账户,这通常可以通过在你的手机上打开相应的应用程序并输入你的用户名和密码来完成。

3. 找到你的订阅

在你的账户页面上,你应该能够看到你所有的订阅,这可能包括音乐流媒体服务、视频流媒体服务、新闻应用等,找到你想要取消的订阅。

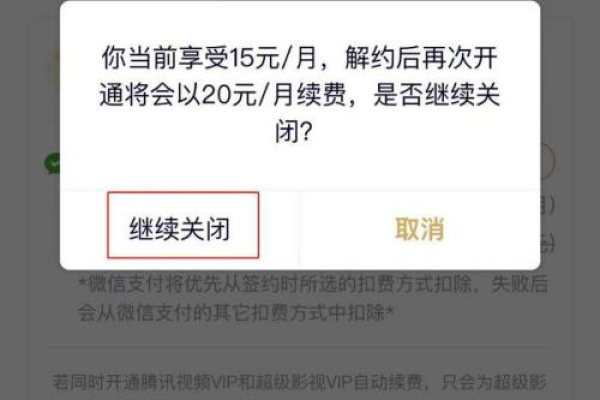

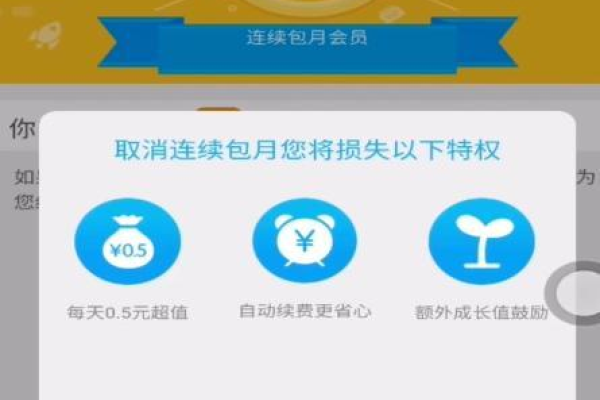

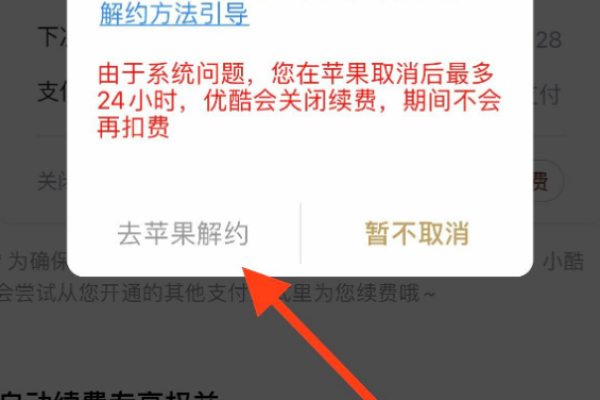

4. 取消订阅

点击你想要取消的订阅,然后选择“取消订阅”或类似的选项,你可能需要确认你的决定,这通常通过点击一个弹出窗口上的“是”或“确认”按钮来完成。

5. 等待取消生效

一旦你取消了订阅,你将不再被收取未来的费用,你可能仍然可以访问该服务,直到你的当前订阅期结束,这通常在你的账户页面上有一个明确的日期。

6. 检查你的银行账户或信用卡账单

为了确保你已经成功取消了订阅并且不再被收费,你应该检查你的银行账户或信用卡账单,你应该看到一个已经停止的订阅费用。

7. 联系服务提供商

如果你无法取消订阅,或者你仍然被收取费用,你应该联系你的服务提供商,他们应该能够帮助你解决问题。

取消手机包月服务是一个相对简单的过程,但是有一些重要的提示你应该记住:

在取消订阅之前,确保你已经下载了你想要保留的所有内容,因为一旦你取消了订阅,你可能就无法再访问这些内容了。

如果你不确定你是否能够取消订阅,你应该查看你的服务提供商的条款和条件,他们应该提供一个明确的取消政策。

如果你在取消订阅后仍然被收费,你应该立即联系你的服务提供商,他们可能会为你的错误负责,并退还你被收取的费用。

FAQs

Q1: 我可以在取消手机包月服务后立即使用我下载的内容吗?

A1: 是的,一旦你取消了手机包月服务,你应该可以立即使用你已经下载的内容,这可能会根据你的服务提供商的政策而变化,所以最好在取消服务之前检查这一点。

Q2: 如果我在取消手机包月服务后仍然被收费,我应该怎么做?

A2: 如果你在取消手机包月服务后仍然被收费,你应该立即联系你的服务提供商,他们应该能够帮助你解决这个问题,可能会退还你被收取的费用,如果服务提供商没有回应或者不能解决你的问题,你可能需要联系你的银行或信用卡公司,或者考虑报告这个问题给消费者保护机构。