网络电视盒和路由器怎么连接

- 行业动态

- 2024-05-06

- 7

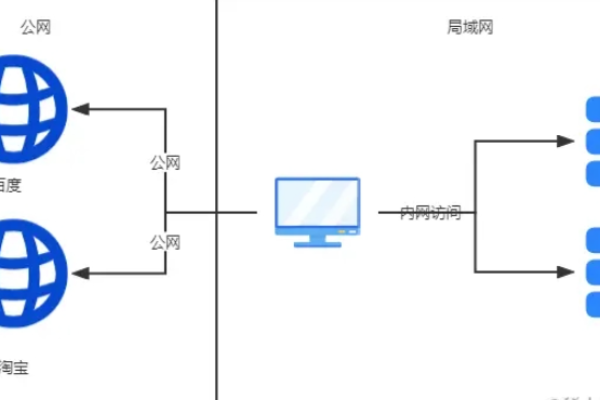

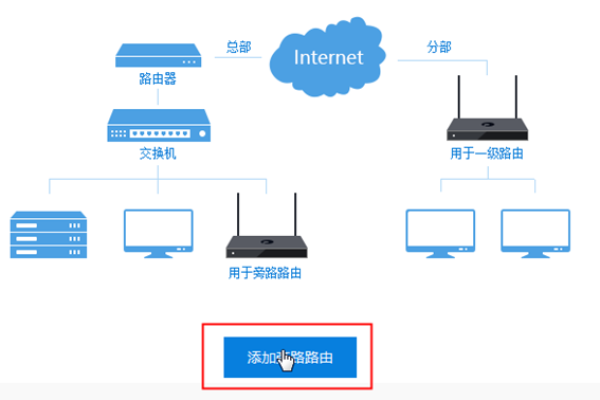

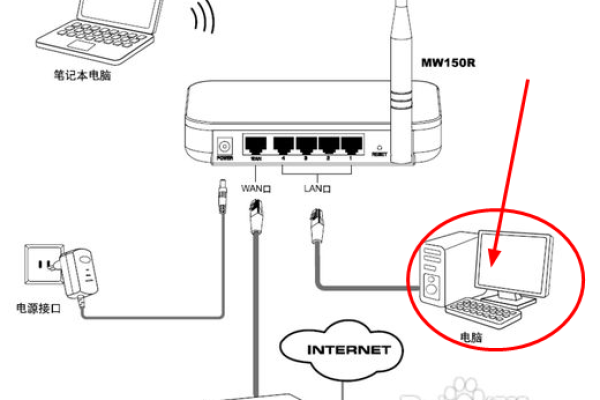

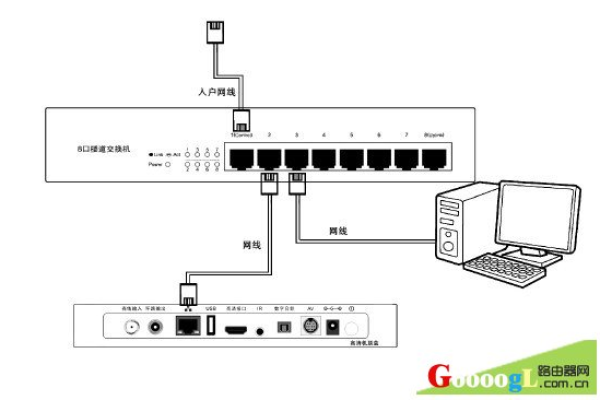

网络电视盒通过HDMI线连接到电视的HDMI接口,然后通过网线将电视盒的网口与路由器的LAN口连接,确保电视盒与 路由器在同一局域网内,即可实现联网功能。

网络电视盒和路由器是两种不同的设备,它们各自具有独特的功能和用途,以下是关于这两种设备的详细信息:

1. 网络电视盒

1.1 定义

网络电视盒是一种可以连接到电视的设备,使电视能够访问互联网并运行各种应用程序,如视频流媒体服务、游戏和其他娱乐内容。

1.2 功能

提供对互联网的访问

支持各种流媒体服务,如Netflix、YouTube等

允许用户安装和使用各种应用程序

提供多媒体播放功能,如音乐和视频播放

支持一些互动功能,如社交媒体应用

1.3 优点

将传统电视升级为智能电视,提供更多功能和内容

用户可以自由安装和卸载应用程序,根据个人喜好定制电视体验

通常比智能电视更便宜,是一种经济实惠的选择

2. 路由器

2.1 定义

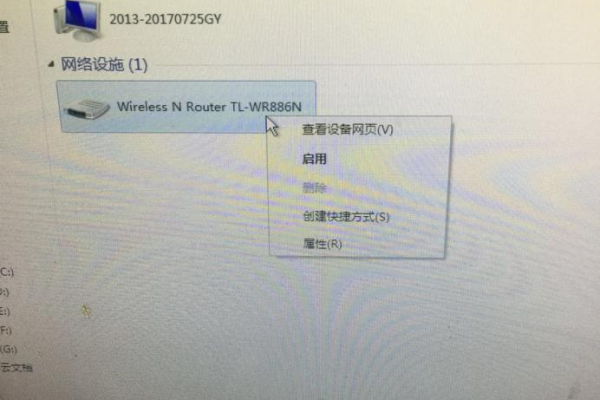

路由器是一种网络设备,用于连接多个设备并将它们连接到互联网,它可以是有线的,也可以是无线的,后者通常被称为无线路由器。

2.2 功能

提供有线或无线网络连接

分配IP地址给连接的设备

管理数据的传输和路由

提供防火墙和安全功能,保护连接的设备免受网络攻击

支持多种网络协议,确保不同设备之间的兼容性

2.3 优点

允许多个设备共享一个互联网连接

提供无线网络,使设备可以在任何地方连接

提供安全功能,保护用户的在线活动和数据

支持高速数据传输,确保流畅的在线体验

3. 比较

| 功能 | 网络电视盒 | 路由器 |

| 互联网访问 | 是 | 是 |

| 应用程序支持 | 是 | 否 |

| 多媒体播放 | 是 | 否 |

| 网络安全 | 有限 | 高 |

| 多设备连接 | 是(有限) | 是(多设备) |

| 数据传输 | 是 | 是 |

| 网络协议支持 | 有限 | 高 |

网络电视盒和路由器是两种不同的设备,各自具有独特的功能和用途,网络电视盒主要用于升级电视的功能,提供更多的内容和应用程序,而路由器则用于连接和管理多个设备的互联网连接,并提供安全功能。