面板套CDN: 如何优化网站性能并提升用户体验?

- 行业动态

- 2024-08-08

- 3

面板套CDN可以有效提升网站的访问速度和安全性,它利用分布式网络缓存内容,将网站数据存储在全球各地的服务器上,从而缩短用户与网站服务器之间的距离,接下来将逐步分析如何将域名绑定到宝塔面板并使用CDN加速:

1、准备工作

域名解析确认:确保域名已正确解析并指向宝塔面板所在的服务器IP地址。

选择CDN服务商:根据需要选择合适的CDN服务商,例如华为云、Cloudflare等。

2、域名绑定

登录CDN服务:登录所选CDN服务商的管理平台,并开通CDN服务。

添加域名:在CDN服务中添加需要加速的域名,并确保域名解析成功。

3、宝塔面板配置

修改宝塔绑定域名:登录宝塔面板,找到网站设置部分,修改域名绑定设置。

4、CDN配置

配置缓存规则:根据网站内容设置合适的缓存规则,以优化CDN的缓存效率。

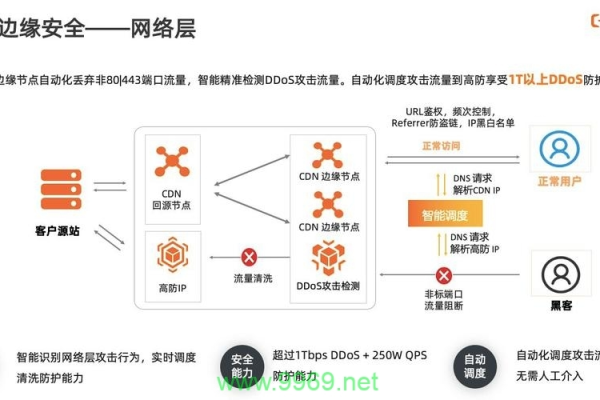

端口配置:注意CDN服务商可能不支持非80和443端口的访问,如使用其他端口,可能需要暂时关闭CDN服务。

5、测试验证

访问测试:通过域名访问网站,检查CDN是否生效,网站是否可以正常访问。

速度和安全测试:使用在线工具测试网站加速效果和安全性。

通过上述步骤,可以将域名成功绑定到宝塔面板并利用CDN加速,考虑到使用的CDN服务商不同,可能会有一些差异,请根据实际情况调整操作步骤。

为了更好地理解整个过程,将提供一些相关的补充信息和注意事项:

确保在绑定域名到宝塔面板前,域名已经正确解析并指向了宝塔面板所在服务器的IP地址。

在选择CDN服务商时,应考虑其网络覆盖、价格、服务质量等因素。

修改宝塔面板配置时,要小心谨慎,避免出现配置错误导致网站无法访问。

如果CDN服务商不支持非标准端口(如80和443以外的端口),在宝塔面板上绑定域名时,需要先关闭CDN服务。

完成配置后,要通过多种方式测试网站访问情况,确保CDN加速效果符合预期。

面板套CDN涉及域名解析、CDN服务商选择、宝塔面板配置等多个步骤,通过遵循上述步骤和注意事项,可以有效地将域名绑定到宝塔面板并实现CDN加速,提升网站的访问速度和用户体验,也要注意测试和监控网站运行状态,确保CDN服务的稳定性和安全性。