当PUBG显示服务器维护中时,玩家该如何应对?

- 行业动态

- 2024-08-04

- 4

PUBG登陆服务器维护中是什么意思?

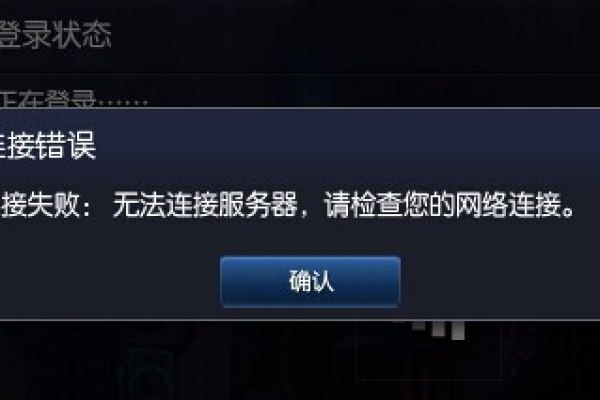

当PUBG显示“登录服务器维护中”的提示时,意味着游戏的服务器正在进行计划性的维护工作,这时玩家无法登录游戏进行游玩,维护工作通常包括修复游戏中的bug、更新游戏内容、优化服务器性能或进行其他技术性调整,这样的维护是为了确保游戏环境的稳定性和流畅性,提供更好的玩家体验。

详细解答

1. 维护的目的

修复bug:游戏在运行过程中可能会出现程序错误,这些bug可能会影响游戏的公平性或导致游戏崩溃,需要及时修复。

更新游戏内容:为了保持游戏的新鲜感和吸引力,开发团队会不定期地添加新的内容,如新的地图、武器、角色定制选项等。

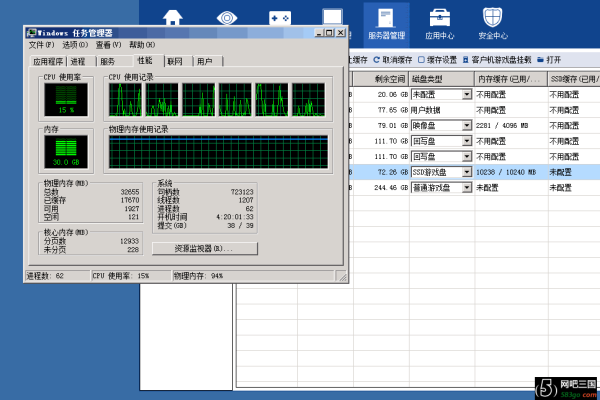

优化性能:提高服务器的运行效率和稳定性,减少游戏延迟和卡顿现象,提升玩家的游戏体验。

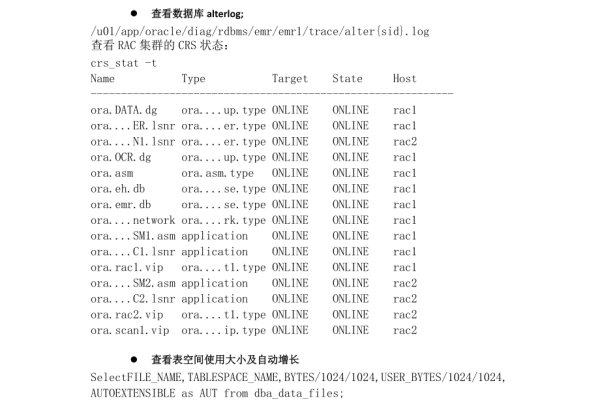

数据库升级:清理垃圾数据、优化数据库性能,保证数据的完整性和安全性。

准备活动:维护也可能是为了准备特殊活动或赛事,确保活动期间游戏服务器的稳定性。

2. 维护的时间和公告

预定时间:游戏公司通常会选择在玩家活跃度相对较低的时段进行维护,以减少对玩家的影响。

公告通知:在维护开始前,游戏公司会通过多种渠道发布维护公告,包括游戏内通知、官方网站、社交媒体等,告知玩家维护的时间和预计持续时长。

3. 维护期间玩家操作

等待维护完成:玩家在维护期间无法登录游戏,只能等待维护完成后才能再次进入游戏世界。

关注更新信息:玩家可以通过官方渠道了解维护的进度和任何新的更新信息。

处理网络问题:如果遇到维护结束后仍无法进入游戏的情况,玩家应检查自己的网络连接或联系客服寻求帮助。

4. 维护完成后的游戏体验

享受改进:维护完成后,玩家将体验到更稳定或更丰富的游戏内容。

查看更新日志:开发团队会发布更新日志,详细说明了维护中所做的更改和新增的内容。

5. 维护对游戏运营的重要性

稳定性和可靠性:定期维护是确保游戏服务稳定性和可靠性的关键措施。

玩家满意度:通过解决游戏中的问题和不断更新内容,维护工作有助于提升玩家的满意度和忠诚度。

6. 玩家如何应对维护

合理安排时间:了解维护公告,并合理安排自己的游戏时间,避免在维护期间尝试登录游戏。

支持和理解:维护是为了提供更好的游戏体验,因此玩家应该理解和支持必要的维护工作。

维护期间的FAQs

1、为什么维护期间无法登录游戏?

维护期间,服务器关闭进行更新和修复,因此无法提供登录和游戏服务。

2、维护一般会持续多久?

维护的持续时间因更新内容和修复工作的复杂性而异,具体时间会由开发团队提前公告。

PUBG登录服务器维护中意味着游戏服务器暂时关闭,进行计划性的更新和维护工作,这是为了确保游戏的稳定性和流畅性,提供更好的玩家体验,玩家可以利用这段时间了解最新的游戏更新,合理安排自己的游戏时间,并在维护完成后享受改进后的游戏内容。