如何在JavaScript中使用find函数查找数组中的元素?

- 行业动态

- 2024-12-30

- 4

find函数用于查找数组中满足提供的测试函数的第一个元素。它返回该元素的值,如果没有找到则返回 undefined。

JavaScript中的find函数

JavaScript 的find 方法是一个强大且常用的工具,用于在数组中查找满足指定条件的第一个元素,本文将详细介绍find 方法的定义、用法以及在实际项目中的应用示例。

一、基本定义和语法

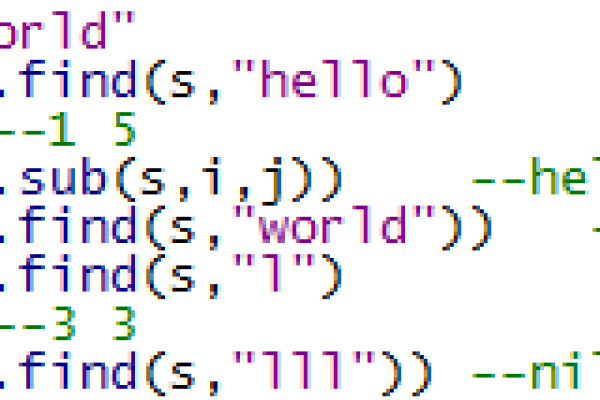

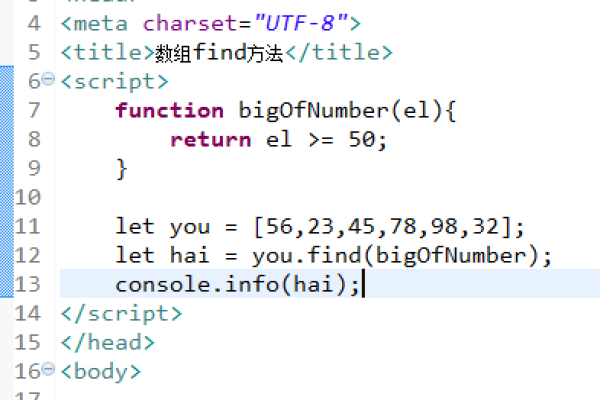

find 方法是数组的一个方法,用于查找数组中满足提供的测试函数的第一个元素,如果没有找到满足条件的元素,则返回undefined,其基本语法如下:

array.find(callback(element[, index[, array]])[, thisArg])

callback: 一个用于测试每个元素的函数,它接受三个参数:

element: 当前处理的数组元素。

index(可选): 当前处理的数组元素索引。

array(可选): 调用了find 方法的数组本身。

thisArg(可选): 执行回调函数时用作this 的值。

二、基本示例

以下是一个简单的find 函数示例:

const numbers = [5, 12, 8, 130, 44]; const found = numbers.find(number => number > 10); console.log(found); // 输出:12

在这个例子中,find 方法查找第一个大于 10 的数字并返回它。

三、多条件查找

在实际开发中,我们常常需要根据多个条件查找数组中的元素,在这种情况下,我们可以将多个条件组合到一个回调函数中,下面的代码查找满足两个条件的对象:年龄大于 20 且为女性。

const people = [

{ name: "Alice", age: 25, gender: "female" },

{ name: "Bob", age: 22, gender: "male" },

{ name: "Clara", age: 30, gender: "female" },

{ name: "David", age: 28, gender: "male" }

];

const foundPerson = people.find(person => person.age > 20 && person.gender === "female");

console.log(foundPerson); // 输出:{ name: 'Alice', age: 25, gender: 'female' } 在这个示例中,find 方法能够有效找到符合特定条件的第一个元素。

四、使用对象和数组存储条件

我们可以使用对象和数组的组合来存储多个条件,以下是一个示例,将条件作为对象存储,并利用find 方法进行查找。

const conditions = {

minAge: 20,

gender: 'female'

};

const foundPerson = people.find(person => person.age > conditions.minAge && person.gender === conditions.gender);

console.log(foundPerson); // 输出:{ name: 'Alice', age: 25, gender: 'female' } 通过封装条件为对象,使代码更加清晰和易于维护。

五、类与方法封装

为了更好地组织代码,我们可以将查找逻辑封装在一个类中,方便进行多次查找,这是采用面向对象编程(OOP)的一种方法,下面是一个简单的类结构:

class Person {

constructor(name, age, gender) {

this.name = name;

this.age = age;

this.gender = gender;

}

}

class PersonFinder {

constructor() {

this.people = [];

}

addPerson(person) {

this.people.push(person);

}

findPersonByConditions(conditions) {

return this.people.find(person =>

person.age > conditions.minAge && person.gender === conditions.gender

);

}

}

// 使用示例

const finder = new PersonFinder();

finder.addPerson(new Person("Alice", 25, "female"));

finder.addPerson(new Person("Bob", 22, "male"));

finder.addPerson(new Person("Clara", 30, "female"));

finder.addPerson(new Person("David", 28, "male"));

const result = finder.findPersonByConditions({ minAge: 20, gender: 'female' });

console.log(result); // 输出:{ name: 'Alice', age: 25, gender: 'female' } 在这个类图中,Person 类用于创建人物对象,而PersonFinder 类则用于存储人物数组并实现查找功能。

六、实际应用场景

find 方法在实际项目中有许多应用场景,

查找用户信息: 在用户管理系统中,常常需要根据用户ID或用户名查找用户信息。find 方法可以高效地完成这个任务。

库存管理: 在库存管理系统中,需要根据商品名称或ID查找具体的库存信息,find 方法可以简化这个过程。

配置查找: 在配置文件或配置数组中,查找符合特定条件的配置项,find 方法也能发挥重要作用。

七、性能注意事项

尽管find 方法非常便捷,但在处理大型数组时,性能可能会成为一个问题,因为find 方法在找到第一个满足条件的元素之前,会遍历数组的每一个元素,所以在大数据集上使用时需要注意性能问题。find 方法与其他数组方法(如filter、map 等)一样,并不会改变原始数组,而是返回一个新的值或undefined。

常见问题与解答(FAQs)

Q1:find 方法在空数组上的行为是什么?

A1: 如果在一个空数组上调用find 方法,它将不会执行回调函数,直接返回undefined,对于空数组,find 方法不会抛出错误,也不会有任何副作用。

Q2:find 方法是否改变原始数组?

A2:find 方法不会改变原始数组,它只是查找并返回符合条件的第一个元素,如果找不到则返回undefined,原始数组的顺序和内容都不会受到影响。

小编有话说

JavaScript 的find 方法是一个非常有用的工具,特别适合需要从数组中查找特定元素的场景,通过了解其基本用法、多条件查找以及在实际项目中的应用,可以更高效地进行数据操作,特别是在项目管理系统中,find 方法能够大大简化查找任务、用户或其他项目元素的操作,提高工作效率,希望本文能帮助你更好地掌握和应用find 方法,让你的代码更加简洁和高效。